Im Gespräch mit Prof. Dr. Stefan Heinemann, Professor für Wirtschaftsethik, FOM Hochschule

Herr Prof. Heinemann, Wie passen Datenschutz und KI zusammen?

Das ist keine einfache Frage. Privatheit ist ein sehr wichtiger Wert, aber nicht der einzige. Hier muss man Abwägungen vornehmen. Ich glaube, dass der Datenschutz, so wie wir ihn in Europa haben, von der ethischen Grundanlage richtig gedacht ist. Aber eben noch nicht optimal, was die Umsetzung und Strukturierung angeht - Stichwort Schutzgutdiskussion. Die ständige Abwägung zwischen Datenschutz und Künstlicher Intelligenz ist problematisch. Wir brauchen einen Datenschutz, der verbindlich ist und der das, was er tun soll, auch pragmatisch leisten kann und somit umsetzbar ist. Wir brauchen bürokratische Strukturen dahinter, die nicht zu komplex sind. Und damit das mit neuesten Technologien funktioniert, brauchen wir auch ein bisschen „Privacy by Design“. Wir müssen schon vor der Entwicklung überlegen, was die möglichen Konsequenzen sind, wie diese in Datenstrukturen eingreifen und wie sie dafür sorgen, dass wir vielleicht gar nicht mitbekommen, was alles passiert. Wir müssen also ständig „à jour“ sein, von der Entwicklung bis zur Praxis in die Umsetzung. Wir brauchen ein ganzheitliches Verständnis von Datenschutz – sowohl von den rechtlichen Aspekten als auch den wirtschaftlichen und ethischen.

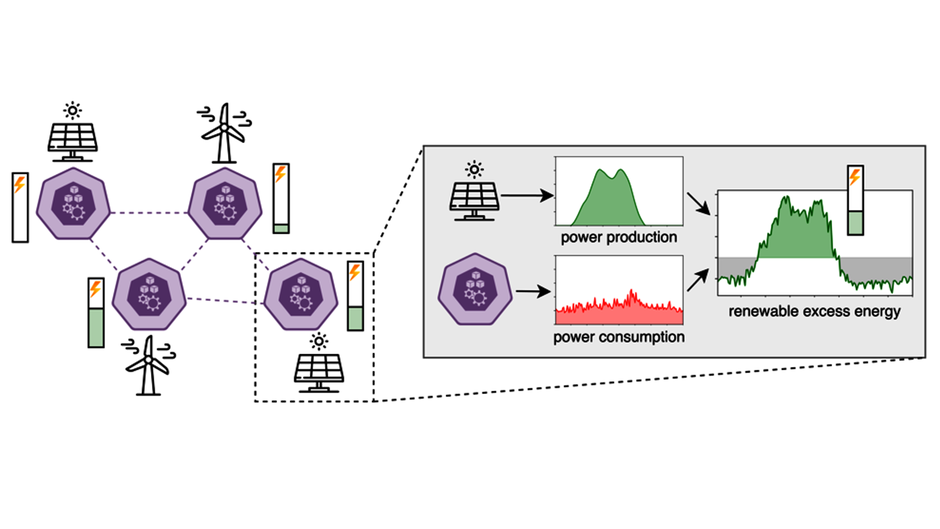

Wenn es KI gäbe, wäre das für den Datenschutz eine immense Herausforderung. Selbst das, was wir heute haben – gutes Machine Learning, gute Mustererkennung – werden seit Jahren diskutiert, kommen aber jetzt immer mehr in die pragmatische Anwendung. Wir haben quasi jeden Tag damit zu tun, auch ohne, dass wir es wissen. Hier ist es natürlich wichtig darauf zu achten, was mit dem Datenschutz passiert. Was passiert, wenn Maschinen untereinander kommunizieren, wenn Daten immer mehr werden, wenn aus Clustern von Daten ganz neue Kontexte entstehen, die auswertbar sind usw. Gerade bei Themen wie Gesundheit werden wir uns in den nächsten Jahren intensiv damit beschäftigen müssen.

Was tragen DSGVO und TI zur Bildung von Vertrauen in den verschiedenen Zielgruppen bei, im Kontext von KI und neuen Technologien?

Vertrauen scheint mir der Schlüssel zu sein. Vertrauen ist soziales Kapital, es geht darum, etwas für wahr zu halten oder zumindest für so wahr zu halten, um daraus eine Überzeugung, eine Handlung abzuleiten. Das Vertrauen gegenüber Strukturen, Marken, Institutionen, Persönlichkeiten, Systemen so entgegenzubringen, dass es kein blindes, sondern ein aufgeklärtes Vertrauen ist. Das ist eine sehr große Aufgabe, die wir noch nicht ansatzweise bewältigt haben. Wir müssen also schauen, wie es um die „data literacy“ bestellt ist, also die Schreib- und Lesefähigkeit, wenn es um Daten geht. Viele Menschen wissen nicht wirklich, was überhaupt „Daten“ bedeutet, was mit Daten passiert – besonders wenn es Gesundheitsdaten sind. Ich denke, da muss man noch viel aufarbeiten. Wenn das Vertrauen und das Verstehen da ist, wenn die Autonomie im Sinne des Begriffs „Würde“ vorhanden ist, wir können alles abwägen, nur die „Würde“ nicht. Da denken wir, dass die schon da sein muss. Und da kann man daraus ableiten, dass wir uns intensiv um Vertrauen und deswegen intensiv um Aufklärung bemühen müssen. Im Schulsystem, im Bildungssystem muss das sinnvoll erzeugt werden. Ein Vertrauen, das auf einem Grundverständnis, einer Idee basiert und nicht einfach ein blindes Vertrauen. Das ist eine gesellschaftliche Frage, fast schon eine gesellschaftliche Utopie, ob wir es schaffen, in einer Gesellschaft zu leben, die wir selber mitgestalten dürfen und die den Begriff „Vertrauensgesellschaft“ verdient.

Sprechen wir statt Vertrauen auch einmal über Transparenz. Was trägt Ihrer Meinung nach der EU-Kodex für Ethik in der KI dazu bei, dass die „black box KI“ geknackt wird und dass hier Transparenz in die KI-Lösung reinkommt?

Ich glaube, entscheidend ist nicht „explainable AI“, also dass wir jetzt alles genau verstehen, was der Code macht. Ich glaube, entscheidend ist die Argumentfähigkeit, dass wir nachvollziehen können wie gewisse Dinge und Ergebnisse zustande kommen. Wir müssen eine Idee haben. Wenn etwas zum Beispiel zu Diskriminierung führt, müssen wir eine Idee haben, warum das so ist und wie wir es verändern können. Wir müssen immer im „driver seat“ bleiben und KI-Anwendungen, die in unsere demokratischen Grundfreiheiten eingreifen, müssen wir verbieten. Hier hat die EU recht. Wir wollen keine Techno-Diktatur haben. Die Frage ist hier, wie man es schafft, die feine Balance zwischen harter Wegregulierung und trotzdem noch Nutzen und Überzeugung für die Wirtschaft und andere Institutionen so hinzubekommen, dass man beides gleichzeitig haben kann. Das Anliegen ist richtig, aber ob wir mit unserem humanzentrierten Umgang anders als mit dem marktzentrierten Umgang wie in den USA oder dem politikzentrierten wie in China, tatsächlich im Wettbewerb Vorrang haben können ist schwierig. Das Gute bringt den Erfolg. Die Frage ist nur wann und wie? Da müssen wir ganz stark im Detail arbeiten und überlegen, wie wir gute und wettbewerbsfähige Geschäftsmodelle nach vorne bringen können. Und das nicht trotz, sondern mit und durch Transparenz und Ethik - und damit einen Wettbewerbsvorteil erzeugen. Das sollte man nicht als Werteballast verstehen, sondern als Vorteil, denn mittel- bis langfristig setzen sich gesellschaftlich legitime und akzeptable Geschäftsmodelle durch. Es gibt immer welche, die mit Dingen, die legal, aber nicht legitim sind, trotzdem Erfolg haben. Aber für die allermeisten gilt das nicht. Und daran müssen wir glauben, davon müssen wir überzeugt sein. Und dafür müssen wir arbeiten. Wir müssen junge Unternehmen unterstützen, die legitime Geschäftsmodelle haben und die sagen, dass sie mit Daten „business“ machen möchten. Das was heißt das genau? Wie können wir maximal offen, maximal transparent sein, wie können wir den Nutzen der Kunden in den Vordergrund stellen, sie aber trotzdem aufklären. Diese Fragen wurden schon immer gestellt. Aber jetzt verändert sich das, weil die Strukturen komplexer und nebulöser werden. Wir durchschauen das alles nicht mehr. Und deswegen ist Transparenz, Aufklärung das Gebot der Stunde. Für die Profis, die damit arbeiten und für alle anderen, die Konsumenten sind. Damit wir nicht am Ende eine Gesellschaft haben, die einerseits aus einer Kaste der Verstehenden, Wissenden besteht und aus 99,9% von Leuten, die gar nicht so richtig wissen, was da passiert. Egal, ob sie damit arbeiten oder nur konsumieren. Das darf nicht sein.

----------------------------

Das Interview wurde im Rahmen des Kongresses ZUKUNFTSMEDIZIN 2021 am 18.06.2021 am Flughafen Essen / Mühlheim geführt.

Interview: Michael Reiter, Kamera: Julian Reiter.