BIFOLD-Forscher demonstrieren FedZero: ein neues System des verteilten Lernens (Förderales Lernen /Federated Learning), das ausschließlich mit grüner Energie betrieben werden kann. Beispielsweise könnte es in der Medizin eingesetzt werden, wenn mehrere Parteien ein medizinisches Vorhersage-Modell mit sensiblen Gesundheitsdaten trainieren möchten. Mit Hilfe des föderalen Lernens bleiben die Datensätze lokal bei dem jeweiligen Partner, ohne dass sie mit anderen Teilnehmern ausgetauscht werden. Der Nachteil: Federated Learning verbraucht enorm viel Energie. FedZero ist so angelegt, dass alle Trainingsprozesse fair verteilt werden und ablaufen, wenn ausreichend grüne Energie zur Verfügung steht.

FedZero macht moderne KI-Modelle energiesparsam

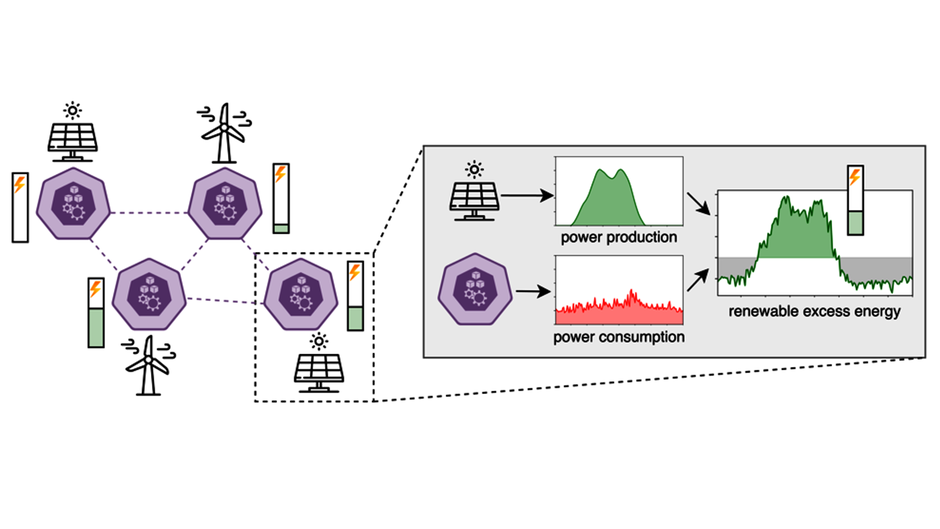

FedZero passt seinen Energieverbrauch an die Verfügbarkeit von überschüssiger erneuerbarer Energie an.

Die meisten Anwendungen maschinellen Lernens laufen heutzutage zentralisiert, was bedeutet, dass alle erforderlichen Trainingsdaten in einem einzigen Datenzentrum vorliegen. In der Praxis möchten verschiedene Parteien jedoch oft gemeinsam ein Modell trainieren, ohne den anderen Parteien ihre Daten zur Verfügung stellen zu müssen. „Zum Beispiel können Gesundheitseinrichtungen keine sensiblen Patientendaten teilen, wollen aber gemeinsam trotzdem Vorhersagemodelle für Diagnosen und Behandlungsempfehlungen entwickeln“, sagt Prof. Dr. Odej Kao, Lehrstuhlinhaber für Verteilte Systeme und Betriebssysteme an der TU Berlin und BIFOLD Fellow. Für solche Anwendungsfälle wurde das sogenannte Federated Learning (verteiltes Lernen) als Alternative zum zentralisierten Training von KI-Systemen entwickelt. Beim Federated Learning werden Modelle dezentral von verschiedenen Partnern trainiert, ohne dass Daten zwischen unterschiedlichen Institutionen übertragen werden müssen.

Wissenschaftler gehen allerdings davon aus, dass die wachsende Nutzung von Federated-Learning-Anwendungen den weltweiten Energieverbrauch des maschinellen Lernens drastisch erhöht. Bereits heute gilt maschinelles Lernen als eine der energieintensivsten Rechenanwendungen. Gerade das Konzept des verteilten Trainings von KI-Modellen in örtlich getrennten Datenzentren bietet neue Chancen, die Ausführung der Rechenanwendungen an die Verfügbarkeit von grüner Energie zu koppeln.

Maschinelles Lernen ohne operative CO2-Emissionen?

BIFOLD-Forscher Philipp Wiesner, Dennis Grinwald, Pratik Agrawal, Lauritz Thamsen, Odej Kao sowie Ramin Khalili vom Huawei Munich Research Center haben genau diese Forschungsfrage untersucht, und demonstrieren, wie Federated Learning ausschließlich mit grüner Energie durchgeführt werden könnte – also ohne zusätzliche CO2-Emissionen zu verursachen. Dafür schlagen sie ein neues System vor, genannt FedZero, das Federated Learning basierend auf der Verfügbarkeit von sogenannter überschüssiger erneuerbarer Energie plant. Überschüssige Energie tritt auf, wenn erneuerbare Quellen wie Sonne oder Wind mehr Strom produzieren als aktuell benötigt wird. FedZero nutzt die überschüssige Energie und koppelt sie an ungenutzte Rechenressourcen. So können die CO2-Emissionen des Trainings effektiv auf null reduziert werden.

Federated-Learning-Projekte, die sich auf die Verwendung von überschüssiger erneuerbarer Energie fokussieren, bringen im Gegenzug jedoch neue Herausforderungen mit sich – ein Thema, das von BIFOLD-Forschenden bereits im Kontext von Cloud-Datenzentren untersucht wurde (siehe auch: https://www.bifold.berlin/news-events/ ... tail/scheduling-computing...). „Beim Federated Learning stoßen wir zusätzlich auf das Problem von Fairness: Partner mit sehr wenig Zugang zu überschüssiger grüner Energie könnten im finalen Modell unterrepräsentiert sein, da ihnen auch entsprechend wenig Trainingszeit zur Verfügung steht“, erklärt Philipp Wiesner. Um genau diese Verzerrung zu verhindern, passt FedZero das Tempo des Trainings dynamisch an die aktuellen Umstände an und optimiert den Trainingsprozess so, dass alle beteiligten Parteien Trainingszeiten in einem angemessenen Umfang erhalten.

Das Paper wird am 5. Juni 2024 auf der "15. ACM International Conference on Future and Sustainable Energy Systems (e-Energy ‘24)" in Singapur vorgestellt.

Weitere Publikationen:

• Philipp Wiesner, Dominik Scheinert, Thorsten Wittkopp, Lauritz Thamsen, Odej Kao: Proceedings of the 28th International European Conference on Parallel and Distributed Computing (Euro-Par): „Cucumber: Renewable-Aware Admission Control for Delay-Tolerant Cloud and Edge Workloads”; Euro-Par 2022: Parallel Processing, pp 218–232, https://doi.org/10.1007/978-3-031-12597-3_14

• Philipp Wiesner, Ilja Behnke, Dominik Scheinert, Kordian Gontarska, Lauritz Thamsen: Let’s Wait Awhile: How Temporal Workload Shifting Can Reduce Carbon Emissions in the Cloud. Middleware '21: Proceedings of the 22nd International Middleware ConferenceDecember 2021, DOI: https://doi.org/10.1145/3464298.3493399

Wissenschaftliche Ansprechpartner:

Originalpublikation:

Philipp Wiesner, Ramin Khalili, Dennis Grinwald, Pratik Agrawal, Lauritz Thamsen, and Odej Kao. "FedZero: Leveraging Renewable Excess Energy in Federated Learning" In the Proceedings of the 15th ACM International Conference on Future and Sustainable Energy Systems (e-Energy).2024. https://dl.acm.org/doi/10.1145/3632775.3639589

Weitere Informationen:

https://www.bifold.berlin/news-events/ ... tail/sustainable-federate... BIFOLD News

Bild: Die Verfügbarkeit von überschüssiger erneuerbarer Energie variiert je nach Zeit und Ort stark. FedZero ermöglicht faires, schnelles und energieeffizientes FL unter solchen stark schwankenden Ressourcenbeschränkungen. ©Philipp Wiesner, Ramin Khalili, Dennis Grinwald, Pratik Agrawal, Lauritz Thamsen,Odej Kao

Quelle: Berlin Institute for the Foundations of Learning and Data – BIFOLD