Kann Künstliche Intelligenz mit Ärzt*innen auf Augenhöhe zusammenarbeiten und ihnen helfen, bessere Diagnosen zu stellen? Mit dieser Frage beschäftigt sich ein Forschungsteam der Universität Bielefeld. Die Informatiker arbeiten an einem interaktiven System, das Ärzt*innen bei der Diagnosefindung begleitet und im Dialog mit ihnen Annahmen überprüft und abwägt. Das soll Entscheidungen transparent und nachvollziehbar machen und Fehldiagnosen vermeiden.

Künstliche Intelligenz (KI) wird in der Medizin immer wichtiger: Intelligente Systeme können große Datenmengen in Sekundenschnelle auswerten, Röntgen- oder Kernspinbilder analysieren, Auffälligkeiten erkennen und Diagnosen stellen.

Doch wie kommt die KI zu ihren Ergebnissen? Hier setzt das Forschungsprojekt C05 im Sonderforschungsbereich 318 „Constructing Explainabilty“ der Universitäten Bielefeld und Paderborn an, in dem es nicht nur um „Diagnosesupport, sondern um Reasoningsupport geht“, macht Professor Dr.-Ing. Stefan Kopp die Herausforderung deutlich.

Das Ziel: Die KI soll nicht einfach fertige medizinische Empfehlungen abgeben, sondern Mediziner*innen bei ihrer Entscheidungsfindung begleiten, Rückfragen stellen und Hypothesen diskutieren.

„Wie eine Art Spurhalteassistent, der während des Diagnoseprozesses darauf achtet, dass die Ärztin oder der Arzt nichts übersieht und Hinweise gibt, was noch zu bedenken ist“, sagt Stefan Kopp, der gemeinsam mit Professor Dr. Philipp Cimiano und zwei Doktoranden an dieser Grundlagenforschung arbeitet. Herzstück ist das KI-System ASCODI, ein Prototyp, den die Informatiker und Kognitionswissenschaftler entwickelt haben und weiter verfeinern, damit Mensch und Maschine als Team zusammenarbeiten und Schritt für Schritt zu einer guten Diagnose kommen. „Und das heißt nicht nur möglichst richtig, sondern auch nachvollziehbar und begründbar“, sagt Kopp.

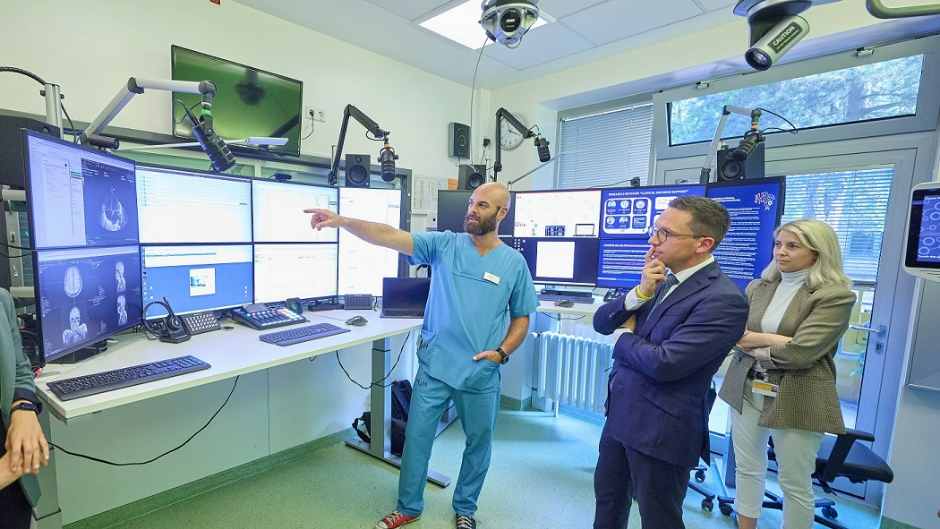

Foto: Dominik Battefeld und Stefan Kopp diskutieren die Ergebnisse des KI-Systems ASCODI.© Andreas Zobe

Zur Veranschaulichung schaltet Doktorand Dominik Battefeld den Bildschirm ein und schlüpft in die Rolles eines Arztes, der das „assistive co-constructive differential diagnosis system“, kurz ASCODI, nutzt. Mit einem Klick auf „Diagnose starten“ stellt sich ihm eine simulierte Patientin vor, weiblich, 32 Jahre alt, mit starkem Husten. Über ein Dashboard checkt Dominik Battefeld weitere Informationen und fragt dann die KI: Was soll ich als nächstes tun? ASCODI erinnert ihn daran, Fieber und Erbrechen abzuklären und gibt eine Einschätzung, wie wahrscheinlich oder unwahrscheinlich Krankheit x oder y ist. „Das ist wie ein virtueller Kollege, mit dem ich den Fall bespreche“, sagt Battefeld. Das smarte Assistenzsystem gibt Antworten, greift aber auch proaktiv ein, stellt selbst Fragen und zieht im Zweifelsfall „rote Linien“. Es warnt zum Beispiel, dass es zu diesem Zeitpunkt nicht gerechtfertigt ist, die Hypothese auszuschließen, die Dominik Battefeld gerade löschen will.

Die KI soll verstehen, wie Ärzt*innen denken

Damit ASCODI all dies leisten kann, wurde das KI-System zunächst mit medizinischen Informationen gefüttert und darauf trainiert, Symptome mit Krankheiten zu verknüpfen. Hinterlegt ist unter anderem ein Datensatz mit 1,3 Millionen simulierten Patient*innen. Doch die Bielefelder Kognitionswissenschaftler gehen noch einen Schritt weiter. Ihr Modell soll verstehen, wie Ärzt*innen denken und bei Diagnosen vorgehen. „Das gibt es so noch nicht“, betont Stefan Kopp. Medizinische Entscheidungen sind komplex und jeder Arzt, jede Ärztin, hat eine eigene Strategie. Grob unterscheiden die Forscher zwei Typen: Diejenigen, die aufgrund von Wissen und Erfahrung schnell und intuitiv eine Hypothese entwickeln, und den analytischen Typ, der viele Informationen sammelt und langsamer arbeitet. ASCODI soll das Vorgehen erkennen und im Falle von „cognitive biases“, also kognitiven Verzerrungen gegensteuern. Hat jemand viel Fachwissen in einem Bereich und läuft Gefahr, andere Möglichkeiten zu übersehen? Legen sich Ärzt*innen zu früh auf eine Diagnose fest und beachten nur noch das, was ihre Annahme unterstützt? In der Praxis komme es immer wieder zu solchen Fehleinschätzungen, vor allem wenn unter Zeitdruck gearbeitet werde, sagt Kopp. „Man geht von einer Fehlerquote bei Diagnosen von bis zu zehn Prozent aus.“

Kann ASCODI diese Rate senken?

Regelmäßig besprechen die Wissenschaftler ihre Ergebnisse mit Fachleuten aus Kliniken in ganz Deutschland. Philipp Cimiano hat zum Beispiel in einer Studie untersucht, wie Ärzt*innen auf Vorschläge der KI reagieren und wie sie diese aus fachlicher Sicht einschätzen. „Wir entwickeln Ansätze, durch die Diagnosen, die von einer KI vorgeschlagen werden, gegenüber behandelnden Ärzt*innen begründet werden können“, sagt er. Bisherige Ergebnisse zeigen, dass gängige Ansätze der sogenannten Explainable AI zu kurz greifen. „Ärzt*innen benötigen argumentative Begründungen, welche die Fakten präsentieren und daraus statistische Schlüsse ziehen. Die Begründungen dürfen allerdings auch nicht zu komplex sein, denn Ärzt*innen haben nur begrenzte zeitliche Ressourcen, um sich mit Erklärungen von KI-Systemen auseinanderzusetzen.“

Kooperationspartner sind unter anderem das Epilepsiezentrum in Bochum und die Universitätsklinik für Epileptologie im Krankenhaus Mara in Bielefeld-Bethel. Die Epileptologie eigne sich gut für die Forschung, denn die Untersuchung von epileptischen Anfällen ist komplex. Dr. med. Christian Brandt, Leitender Abteilungsarzt am Epilepsiezentrum Bethel und Professor für Epileptologie an der Universitätsklinik, sieht gute Chancen, dass die Technologie die Diagnosefindung präziser und schneller machen kann: „Ein Risiko sehe ich aber, wenn die KI als Blackbox undurchschaubar ist.“ Genau das soll ASCODI verhindern.

Weitere Studien müssen zeigen, ob der Prototyp die Erwartungen erfüllt. Wie wirkt sich die Kooperation auf ärztliches Handeln aus? Funktioniert die Zusammenarbeit in der Praxis? Wo sind Grenzen? Führt die Technologie vielleicht sogar dazu, dass sich Nutzer*innen zu sehr darauf verlassen und zu viel Verantwortung an die Maschine abgeben? Im kommenden Jahr soll es dazu Tests geben. Denkbar ist auch, das System in der Ausbildung oder als Trainingstool einzusetzen. Für die Forschenden ist es in jedem Fall eine wissenschaftlich spannende Aufgabe mit gesellschaftlicher Relevanz. „Ein mathematisches Modell davon zu haben, wie und warum Ärzt*innen zu unterschiedlichen Diagnosen kommen, das ist eine wissenschaftliche Herausforderung und hat einen Mehrwert, wenn es funktioniert“, sagt Dominik Battefeld, und auch Stefan Kopp sieht großes Potenzial in der Grundlagenforschung. „Technologie so einzusetzen, dass sie stark belastete Ärzt*innen unterstützt und Fehldiagnosen reduziert, ist eine spannende und vielversprechende Anwendungsperspektive.“

Quelle: ©Uni Bielefeld

Symbolbild: Smolaw11/Adobe Stock